AI 도입이 바꾸는 데이터센터 구조

AI 학습과 추론은 전례 없는 고성능 연산과 고밀도 전력을 요구합니다.

기존 데이터센터는 보통 **랙(Rack)**당 5~10kW 전력만 지원했지만, 최신 AI 워크로드는 랙당 20~100kW, 일부는 그 이상까지 요구하는 추세입니다.

AI 학습용 서버(예: NVIDIA H100/H200 기반 HGX 플랫폼)는 8kW 이상을 단일 서버에서 소비하기도 하며, 다수 장비가 결합될 경우 랙당 수십 kW의 전력 소모가 필수입니다.

고밀도 전력 인프라: UPS 8개 소스 구조

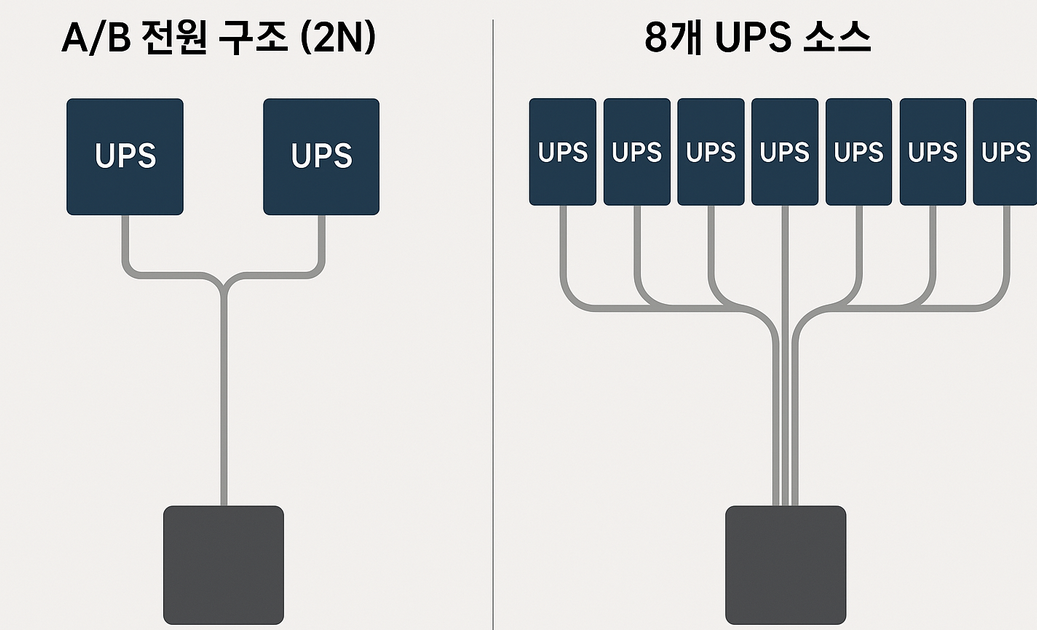

전통적 방식은 "A/B 전원 구조(2N)" 를 기반으로 했지만,

AI 시대에는 8개의 독립된 UPS 소스가 필요할 수 있습니다.

이는 NVIDIA DGX SuperPod나 HGX 시스템 운영 기준에도 반영되어 있습니다.

이 구조는 고장 시 하나의 전원이 다운되어도 다른 전원이 공급을 유지해주는 다중 이중화(Multi-Redundancy) 구조입니다.

🌐 엣지 컴퓨팅과 지연시간 최소화 전략

"AI 추론(Inference)" 은 지연시간이 핵심 성능 요소입니다.

이를 위해 "엣지 데이터센터(Edge DC)" 가 사용자 근처에 배치됩니다.

- 일반 전력 밀도: 5~25kW

- 목적: 지리적 근접성, 빠른 응답 시간

- 적용 사례: 실시간 번역, 자율주행, CCTV 분석 등

🔍 엣지 DC는 중앙 클라우드보다 작지만, 위치와 연결성이 핵심입니다.

❄ 냉각 기술의 혁신: 공기 → 액체 냉각 (Liquid Cooling)

랙당 20~100kW 이상을 지원하기 위해서는 "공기 냉각(Air Cooling)" 으로는 한계가 있으며,

다음의 액체 냉각 기술이 필수로 도입되고 있습니다.

주요 기술:

- Cold Plate 기반 Direct Liquid Cooling (DLC)

- 서버 GPU 내부까지 냉각수 흐름

- 입수 25도 / 배출 45도 수준의 온도차

- CDU(Cooling Distribution Unit)

- 찬물/더운물의 열교환, 배관 및 펌핑 제어

✅ 일부 AI 서버는 DLC 외에도 Immersion Cooling (침지냉각) 도 검토 중이지만, 대규모 상용화는 아직 제한적입니다.

데이터센터의 플랫폼화: Meeting Place 전략

과거에는 단순 코로케이션(Colocation, 물리 공간 제공)이 중심이었지만,

이제는 다양한 서비스가 상호 연결된 플랫폼화 전략이 중심입니다.

- 클라우드, AI, 네트워크 사업자 간 직접 연결

- Cross Connect를 통해 초고속 내부망 연결 지원

- 다양한 API/클라우드 서비스에 저지연 연결 가능

🔄 이는 기업의 DevOps/AIOps 환경을 대폭 간소화하고, 빠른 서비스 출시가 가능합니다.

미래 데이터센터의 핵심 트렌드 요약

| 전력 밀도 | 랙당 35kW → 100kW 이상 |

| 냉각 기술 | 공기 냉각 → 액체 냉각(DLC, CDU) |

| 전원 인프라 | A/B 전원 → 8개 이상 UPS 멀티소스 |

| 지연 시간 | 엣지 DC로 최소화 |

| 기술 생태계 | 데이터센터 → 클라우드/AI 연동 플랫폼 |

결론

AI 시대에는 기존 인프라로는 대응이 어렵습니다.

고성능 컴퓨팅(HPC), AI 학습 및 추론, 지연 민감 서비스 운영에는 고밀도 전력, 액체 냉각, 그리고 위치 기반 엣지 컴퓨팅이 핵심입니다.

디지털 리얼티는 이러한 요구를 충족하는 글로벌 리더로,

안정성과 확장성, 그리고 즉시 연결성을 갖춘 미래형 데이터센터를 제공합니다.

📌 기업이 AI 도입을 고려 중이라면, 이러한 인프라 전략은 선택이 아닌 필수입니다.

주요 기술 용어 & 개념 설명

🔌 랙(Rack)

- 정의: 서버나 네트워크 장비를 수직으로 쌓아 올리는 표준화된 구조.

- 크기 예시: 일반적으로 42U(유닛) 높이. 1U는 약 4.45cm 정도이며, 1U 서버는 아주 얇은 서버를 의미합니다.

- 비유: 서버 전용 ‘책장’으로 생각하면 쉬움.

⚡ kW (킬로와트)

- 정의: 전력의 단위. 1kW는 1,000와트(W).

🔋 UPS (Uninterruptible Power Supply)

- 정의: 정전이 되어도 서버가 꺼지지 않도록 백업 전원을 공급하는 장치.

- 역할: 서버의 ‘배터리’ 같은 존재. 정전 시 잠깐 동안 전력을 공급하거나 자동 전환.

🔌 멀티소스 전원 구조

- 정의: 전원을 한 곳에서만 받지 않고, 여러 UPS나 발전기 등 다양한 경로에서 분산해서 받는 방식.

- 장점: 한쪽 전원이 고장 나도 시스템은 계속 작동함 → 고가용성 확보.

❄ 공기 냉각(Air Cooling)

- 정의: 선풍기처럼 찬 공기를 서버에 불어넣어 열을 식히는 방식.

- 한계: 고밀도 서버에선 열이 너무 많아 공기만으론 식히기 힘듦.

💧 액체 냉각(Liquid Cooling)

- 정의: 물(또는 특수 냉각액)을 이용해 서버를 직접 식히는 기술.

- 종류:

- DLC (Direct Liquid Cooling): 냉각수가 서버 내부의 콜드 플레이트를 지나가며 열을 직접 흡수.

- Immersion Cooling: 서버를 아예 냉각액에 담가버리는 방식 (비교적 실험적이지만 효과 좋음).

🧊 콜드 플레이트 (Cold Plate)

- 정의: 서버 부품 위에 얇게 붙이는 금속판. 냉각수가 지나가면서 열을 흡수하는 장치.

- 역할: 열을 가장 많이 발생시키는 GPU, CPU 부위에 직접 부착됨.

🌡 CDU (Cooling Distribution Unit)

- 정의: 서버로 보내는 찬 물과 서버에서 나오는 더운 물을 관리하는 유닛.

- 비유: 물 순환을 조절하는 ‘냉각 컨트롤 타워’ 같은 역할.

🌐 엣지 컴퓨팅 (Edge Computing)

- 정의: 데이터를 사용자 가까이 있는 서버에서 처리해 빠르게 응답하는 방식.

- 예시: 자율주행차, AR/VR, 실시간 감시 카메라 등은 지연 시간이 아주 민감해서 엣지 서버가 필요함.

📉 지연 시간 (Latency)

- 정의: 요청을 보낸 후 응답이 올 때까지 걸리는 시간.

- 단위: 보통 밀리초(ms). 낮을수록 빠름.

- 중요성: AI 추론, 실시간 게임, 영상 스트리밍에 매우 중요.

🔄 콜로케이션 (Colocation)

- 정의: 기업이 자체 서버를 구매해서, 타사의 데이터센터에 입주시켜 운영하는 방식.

- 비유: 내 컴퓨터를 남의 건물에 넣고 인터넷, 전기, 보안은 그쪽에서 해주는 구조.

🔗 Cross Connect (크로스 커넥트)

- 정의: 같은 데이터센터 안에 있는 고객 간, 또는 고객과 클라우드 간의 전용 고속 연결 회선.

- 장점: 인터넷을 거치지 않고 빠르고 안전하게 연결 가능.

예) 은행 → 클라우드 서비스 실시간 연동 시 사용.

☁ Meeting Place 플랫폼

- 정의: 디지털 리얼티 같은 데이터센터 사업자가 제공하는 통합 네트워크/서비스 연동 플랫폼.

- 역할: 서버를 두기만 하면 다양한 클라우드, 통신사, API와 바로 연결 가능하게 해주는 ‘네트워크 허브’.

🤖 AI 추론 (Inference)

- 정의: 학습된 AI 모델이 실제로 판단/예측/생성 작업을 수행하는 단계.

- 예시: ChatGPT가 질문에 답하는 과정, 이미지에서 얼굴 인식하는 과정 등.